-

GPU Cloud For AISKT

GPU Cloud For AISKT Lambda가 제공하는 국내 최대 규모의 GPU Cloud

Get in Touch

Lambda가 제공하는 국내 최대 규모의 GPU Cloud

Get in Touch -

AI DC Total SolutionSKT Enterprise가 제공하는 국내 최대 규모의 GPU CloudGet in Touch

AI DC Total SolutionSKT Enterprise가 제공하는 국내 최대 규모의 GPU CloudGet in Touch

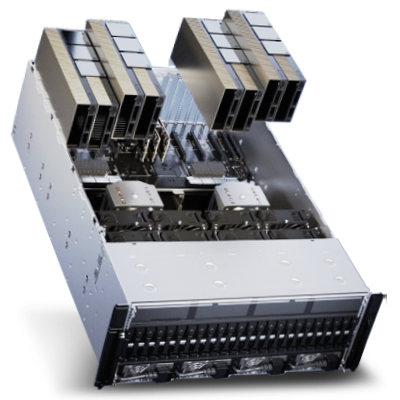

NVIDIA H100

AI와 HPC 작업에 최적화된 4세대 Tensor코어를 탑재한 고성능 GPU

NVIDIA H200

H100의 후속 모델로 전작 대비 성능이 최대 45% 향상된 고성능 GPU

대규모 학습을 위한 최신 GPU기반의 인프라

지연이나 병목 현상 없이 수천 개의 NVIDIA H100, H200 GPU를 활용하여 대규모 모델을 트레이닝하고 AI 프로젝트를 위한 최신 인프라를 제공합니다.

대규모 학습을 위한 최신 GPU기반의 인프라

최고의 성능을 보장하는 Compute Fabric

각 GPU는 Private Cloud compute fabric과 1:1로 연결되어 전용 400Gbps 링크를 통해 연결됩니다. Multi-PB/s 처리량으로 확장 가능한 GPU 컴퓨팅을 위한 최적의 네트워크 topology를 제공합니다.

최고의 성능을 보장하는 Compute Fabric

Throughput을 최대화한 Non-Blocking InfiniBand

클러스터의 내 모든 GPU에 동시에 Full Bandwidth를 제공하는 가장 빠른 네트워크입니다. InfiniBand를 활용하여 대규모 분산 훈련을 최적화하며 전체 클러스터에서 효율적으로 작동합니다.

Throughput을 최대화한 Non-Blocking InfiniBand

세계 50위권 슈퍼 컴퓨터 TITAN 구축/운영 경험

아키텍쳐 성능최적화로 성능 효율 87% 달성

국내 제 1 금융권 구축 레퍼런스 보유

AI 워크로드에 최적화된 DC 기술 보유

국내 최초 44kW 랙 도입

Global Top Player와 미래 AI DC 기술 공동 개발(DLC, 액침냉각 등)

최신 GPU를 국내에서 가장 빠르게 확보

NVIDIA 최신 GPU를 우선 배정받은 Lambda와 전략적 파트너 협업을 통한 Supply chain 구축

세계 최고 수준 대규모 Cluster 최적화 기술 확보

GPU Cluster, AI SW, 냉각 기술을 통합한 AI Factory 구축 Reference 보유